En este artículo trataremos sobre Internet Archive y Wayback Machine: cómo recuperar la información eliminada de los sitios, cómo descargar ya sitios inexistentes y otros ejemplos y casos de uso.

El principio de funcionamiento de todos los Internet Archive (Archivos de Internet) es similar: alguien (cualquier usuario) indica una página para guardar. El Internet Archive la descarga, incluyendo el texto, las imágenes y los estilos de diseño, y la guarda. Si se solicita, la página guardada puede verse desde el Internet Archive, y no importa si la página original ha cambiado o si el sitio no está disponible o ha dejado de existir por completo.

Muchos Archivos de Internet almacenan varias versiones de la misma página, tomando una instantánea de la misma en diferentes momentos. Gracias a ello, se puede rastrear el historial de cambios del sitio o página web a lo largo de los años de su existencia.

Este artículo mostrará cómo encontrar información borrada o modificada, cómo utilizar los Internet Archive para restaurar sitios, páginas individuales o archivos, así como algunos otros casos de uso.

Wayback Machine es el nombre de uno de los populares sitios de archivos de Internet. A veces, Wayback Machine se utiliza como sinónimo de Internet Archive.

Tabla de Contenido

- ¿Qué Archivos de Internet existen?

- Cómo Usar web.archive.org

- Changes o Cambios

- Cómo Usar archive.md

- ¿Qué Sucede si la Página Eliminada no se Guarda en Ninguno de los Archivos?

- Cómo Descargar Completamente un Sitio de un Archivo Web

- Cómo Descargar Todos los Cambios de Página de un Archivo Web

- Cómo Averiguar Todas las Páginas de un Sitio que están Guardadas en Internet Archive

- Conclusión

- ¿Qué Archivos de Internet existen?

- Cómo Usar web.archive.org

- Changes o Cambios

- Cómo Usar archive.md

- ¿Qué Sucede si la Página Eliminada no se Guarda en Ninguno de los Archivos?

- Cómo Descargar Completamente un Sitio de un Archivo Web

- Cómo Descargar Todos los Cambios de Página de un Archivo Web

- Cómo Averiguar Todas las Páginas de un Sitio que están Guardadas en Internet Archive

- Conclusión

¿Qué Archivos de Internet existen?

Conozco tres archivos de páginas web (si conoces más, escríbelos en los comentarios):

- https://web.archive.org/

- https://archive.md/ (también utiliza los dominios https://archive.ph/ y https://archive.today/)

- https://archive.fo/

Cómo Usar web.archive.org

Este servicio de archivo web también se conoce como Wayback Machine. Dispone de varias funciones adicionales, la mayoría de ellas utilizadas por herramientas para restaurar sitios e información.

Para guardar la página en el archivo, dirígete a https://archive.org/web/, introduce la dirección de la página que te interesa y haz clic en el botón ‘SAVE PAGE‘.

Para ver las versiones guardadas disponibles de la página web, ve a https://archive.org/web/, introduce la dirección de la página que te interesa o el dominio del sitio web y haz clic en ‘BROWSE HISTORY‘:

En la parte superior dice cuántas instantáneas totales de la página se han tomado, la fecha de la primera y la última instantánea.

A continuación hay una escala de tiempo en la que se puede seleccionar el año de interés, al elegir un año, el calendario se actualizará.

Los puntos en el calendario significan diferentes eventos, diferentes colores tienen diferentes significados sobre la captura de la web. El azul significa que al archivar la página desde el servidor web se recibió un código de respuesta 2XX (todo está bien); el verde significa que el rastreador ha recibido el estado 3XX (redirección); el naranja significa que el estado es 4XX (error en el lado del cliente, por ejemplo, la página no se encontró), y el rojo significa que el archivo recibió un error 5XX (problemas en el servidor). Lo más probable es que te interesen los puntos y enlaces azules y verdes.

Al hacer clic en la hora seleccionada, se abrirá un enlace, por ejemplo, y se mostrará cómo era la página en ese momento:

Con estos iconos, puede ir a la siguiente instantánea de la página, o saltar a la fecha deseada:

La mejor manera de ver todos los archivos que se han archivado para un sitio concreto es abrir un enlace como https://web.archive.org/*/www.sitioweb.com, por ejemplo:

https://web.archive.org/web/*/esgeeks.comAdemás del calendario, están disponibles las siguientes páginas:

- Colecciones. Disponibles como funciones adicionales para los usuarios registrados y mediante suscripción.

- Changes (Cambios)

- Summary (Resumen)

- Site Map (Mapa del sitio)

Changes o Cambios

Changes es una herramienta que puedes utilizar para identificar y mostrar los cambios en el contenido de las URL archivadas.

Puedes empezar seleccionando dos días diferentes de una URL. Para ello, haz clic en los puntos correspondientes:

Y haz clic en el botón Compare. Como resultado, se mostrarán dos opciones de página. El amarillo indica el contenido eliminado, y el azul indica el contenido añadido.

Summary o Resumen

En esta pestaña, se muestran estadísticas sobre el número de cambios de tipos MIME.

Site map o Mapa de sitio

Como su nombre indica, aquí se muestra un diagrama del mapa del sitio, mediante el cual puedes ir al archivo de la página que te interesa.

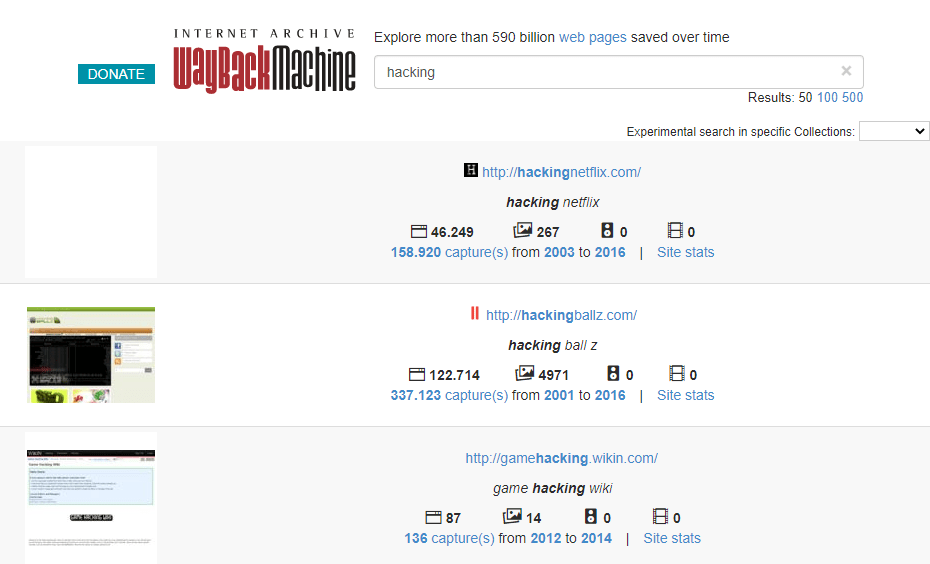

Buscar en el Internet Archive

Si en lugar de la dirección de la página introduces otra cosa, se realizará una búsqueda en los sitios archivados:

Visualizar la página de una fecha determinada

Además de utilizar el calendario para ir a la fecha deseada, puedes ver la página de la fecha deseada utilizando el siguiente formato:

https://web.archive.org/web/YYYYMMDDHHMMSS/DIRECCION_PAGINA/Ten en cuenta que en la línea YYYYMMDDHHMMSS puedes omitir cualquier número de dígitos finales.

Si no se encuentra ninguna copia de archivo en la fecha deseada, se mostrará la versión para la fecha disponible más cercana.

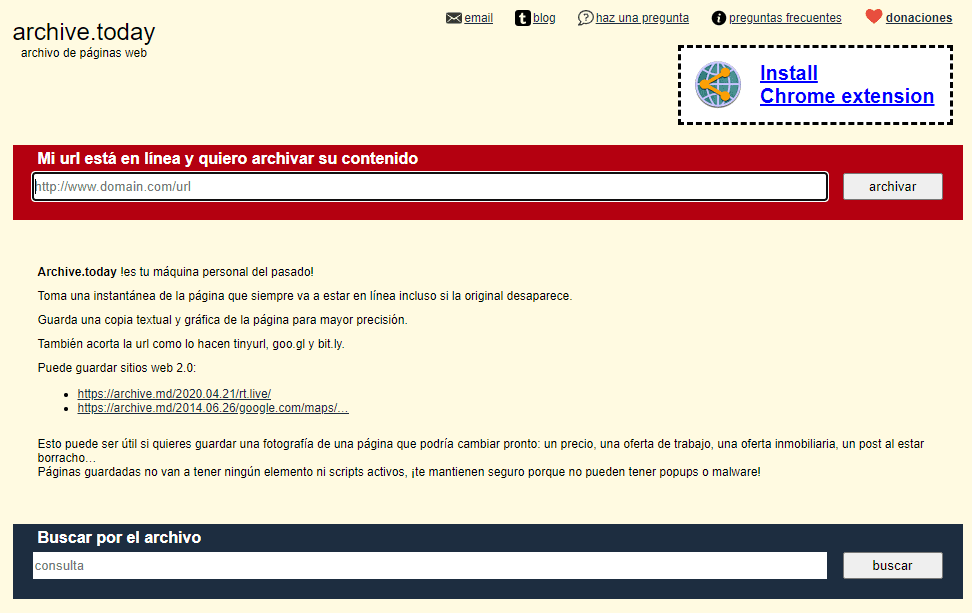

Cómo Usar archive.md

En la página principal, los campos que se explican por sí mismos son

- Mi URL está en línea y quiero archivar su contenido

- Buscar por el archivo

Para buscar en las páginas guardadas, puedes especificar una URL concreta o dominios, por ejemplo

- microsoft.com mostrará las imágenes del host microsoft.com

- *.microsoft.com mostrará las imágenes del host microsoft.com y todos sus subdominios (por ejemplo, www.microsoft.com)

- https://twitter.com/burgerking mostrará el archivo de la URL dada (la búsqueda distingue entre mayúsculas y minúsculas)

- https://twitter.com/burg* buscará las URLs archivadas que empiecen por http://twitter.com/burg

Este servicio guarda las siguientes partes de la página

- Contenido de texto de la página web

- Imágenes

- Contenido de los Frames

- Contenido e imágenes cargadas o generadas mediante JavaScript en sitios Web 2.0

- Capturas de pantalla de 1024×768 píxeles.

Las siguientes partes de las páginas web no se guardan

- Flash y el contenido que carga

- Vídeo y sonidos

- Las páginas RSS y otras páginas XML no se guardan. La mayoría de ellas no se guardan, o se guardan como páginas en blanco.

La página archivada y todas las imágenes deben ocupar menos de 50 megabytes.

Para cada página archivada se crea un enlace de la forma https://archive.is/XXXXX, donde XXXXX es el identificador único de la página. Además, se puede acceder a cualquier página archivada de la siguiente manera

- https://archive.is/2012/http://www.google.es/ es la instantánea más reciente de 2012.

- https://archive.is/201201/http://www.google.es/ – la instantánea más reciente de enero de 2012.

- https://archive.is/20120101/http://www.google.es/ – la instantánea más reciente del día 1 de enero de 2012.

La fecha puede continuar indicando horas, minutos y segundos:

- https://archive.is/2012010103/http://www.google.es/

- https://archive.is/201201010313/http://www.google.es/

- https://archive.is/20120101031355/http://www.google.es/

Para mejorar la legibilidad, el año, el mes, el día, las horas, los minutos y los segundos pueden separarse con puntos, guiones o dos puntos:

- https://archive.is/2012-0828/http://hakin9.org/

- https://archive.is/2012.08.28-13:08:20/http://hakin9.org/

También es posible hacer referencia a todas las instantáneas de la URL especificada:

- https://archive.is/http://www.google.es/

Todas las páginas de dominio guardadas:

- https://archive.is/www.google.es

Todas las páginas guardadas de todos los subdominios

- https://archive.is/*.google.es

Para acceder a la última versión de una página del archivo o a la más antigua, se admiten direcciones con el siguiente formato:

- https://archive.is/newest/http://reddit.com/

- https://archive.is/oldest/http://reddit.com/

Para acceder a una parte específica de una página larga, hay dos opciones:

- Añadir un hashtag (#) con una posición de desplazamiento porcentual de la cual el número está entre 0 (parte superior de la página) y 100 (parte inferior de la página). Por ejemplo, https://archive.md/ssIXx#95%

- Seleccionar el texto de las páginas y obtener la URL con un hashtag que apunte a esta sección. Por ejemplo, https://archive.md/ssIXx#selection-2161.0-2216.0

Los dominios admiten caracteres nacionales:

- https://archive.is/www.maroñas.com.uy

- https://archive.is/*.测试

Ten en cuenta que al crear una copia de archivo de la página, la dirección IP de la persona que crea la instantánea de la página se envía al sitio archivado. Esto se hace a través de la cabecera X-Forwarded-For para identificar correctamente tu región y mostrar el contenido pertinente.

¿Qué Sucede si la Página Eliminada no se Guarda en Ninguno de los Archivos?

Los archivos de Internet guardan las páginas sólo si algún usuario ha solicitado esta acción – no tienen funciones de rastreo y no buscan nuevas páginas y enlaces. Por esta razón, es posible que la página que te interesa haya sido eliminada antes de que se guardara en algún archivo de Internet.

No obstante, puedes utilizar los servicios de los motores de búsqueda que buscan activamente nuevos enlaces y guardan rápidamente las nuevas páginas. Para visualizar una página de la caché de Google, hay que introducir en la búsqueda de Google:

cache:URLPor ejemplo:

cache:https://esgeeks.com/?p=9193Si introduce una consulta similar en una búsqueda de Google, se abrirá inmediatamente la página de la caché.

- Para ver la versión de texto, puedes utilizar el enlace con el formato siguiente: (cambia URL por tu URL/Enlace)

https://webcache.googleusercontent.com/search?q=cache:URL&strip=1&vwsrc=0- Para ver el código fuente de una página web de la caché de Google, utiliza el siguiente formato: (cambia URL por tu URL/Enlace)

http://webcache.googleusercontent.com/search?q=cache:URL&strip=0&vwsrc=1Cómo Descargar Completamente un Sitio de un Archivo Web

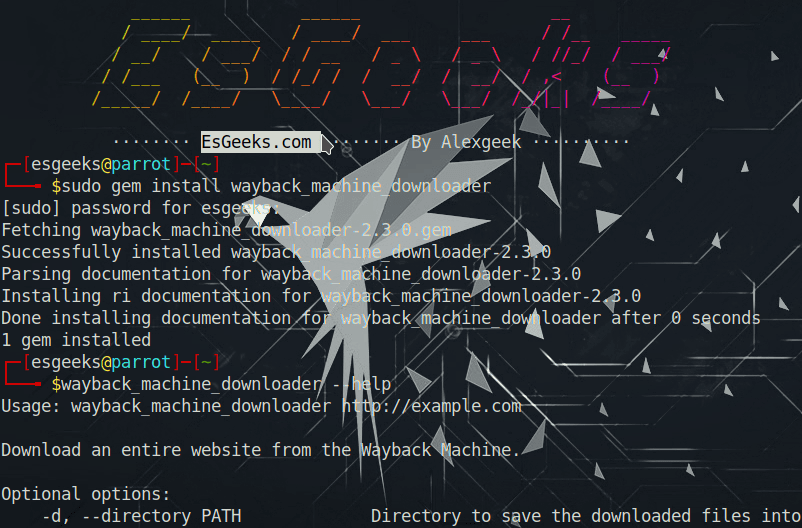

Si quieres recuperar un sitio borrado, Wayback Machine Downloader te ayudará. (Alternativamente, te interesará leer sobre httrack)

El programa descargará la última versión de cada archivo presente en el archivo de Internet de Wayback Machine y la guardará en una carpeta con el formato ./websites/ejemplo.com/. También recreará la estructura de directorios y creará automáticamente las páginas index.html para que el sitio descargado pueda colocarse en el servidor web Apache o Nginx sin ningún cambio.

Para instalar Wayback Machine Downloader en Kali Linux:

gem install wayback_machine_downloader

wayback_machine_downloader --help

Para instalar Wayback Machine Downloader en BlackArch:

gem install wayback_machine_downloader

sudo mv ~/.gem/ruby/2.6.0/bin/wayback_machine_downloader /usr/local/bin/

wayback_machine_downloader --helpUso:

wayback_machine_downloader https://ejemplo.comOpciones:

Optional options:

-d, --directory PATH Directory to save the downloaded files into

Default is ./websites/ plus the domain name

-s, --all-timestamps Download all snapshots/timestamps for a given website

-f, --from TIMESTAMP Only files on or after timestamp supplied (ie. 20060716231334)

-t, --to TIMESTAMP Only files on or before timestamp supplied (ie. 20100916231334)

-e, --exact-url Download only the url provied and not the full site

-o, --only ONLY_FILTER Restrict downloading to urls that match this filter

(use // notation for the filter to be treated as a regex)

-x, --exclude EXCLUDE_FILTER Skip downloading of urls that match this filter

(use // notation for the filter to be treated as a regex)

-a, --all Expand downloading to error files (40x and 50x) and redirections (30x)

-c, --concurrency NUMBER Number of multiple files to dowload at a time

Default is one file at a time (ie. 20)

-p, --maximum-snapshot NUMBER Maximum snapshot pages to consider (Default is 100)

Count an average of 150,000 snapshots per page

-l, --list Only list file urls in a JSON format with the archived timestamps, won't download anything

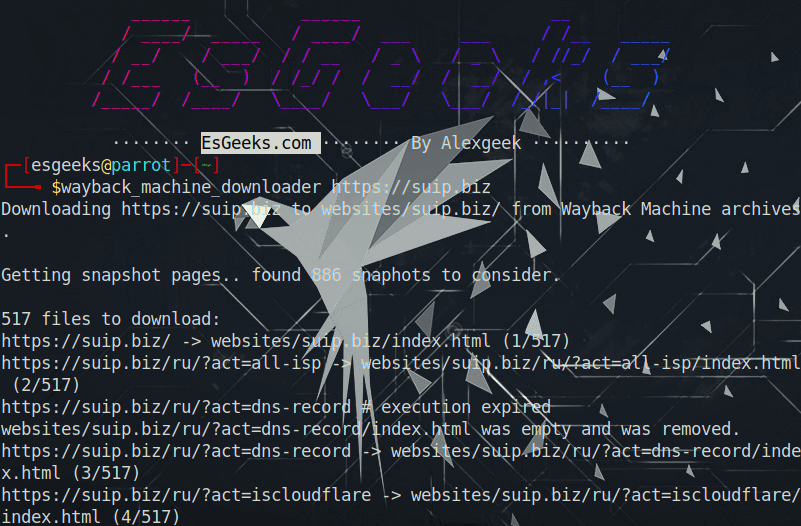

-v, --version Display versionEjemplo de descarga de una copia completa del sitio web suip.biz desde el Internet archive:

wayback_machine_downloader https://suip.biz

La estructura de los archivos descargados:

Cómo Descargar Todos los Cambios de Página de un Archivo Web

Si no te interesa todo el sitio, sino una página específica, pero necesitas rastrear todos los cambios en ella, entonces utiliza el programa Waybackpack.

Para instalar Waybackpack en Kali Linux:

sudo apt install python3-pip

sudo pip3 install waybackpackPara instalar Waybackpack en BlackArch:

sudo pacman -S waybackpackUso:

waybackpack [-h] [--version] (-d DIR | --list) [--raw] [--root ROOT] [--from-date FROM_DATE] [--to-date TO_DATE] [--user-agent USER_AGENT] [--follow-redirects] [--uniques-only]

[--collapse COLLAPSE] [--ignore-errors] [--quiet]

urlOpciones:

positional arguments:

url The URL of the resource you want to download.

optional arguments:

-h, --help show this help message and exit

--version show program's version number and exit

-d DIR, --dir DIR Directory to save the files. Will create this directory if it doesn't already exist.

--list Instead of downloading the files, only print the list of snapshots.

--raw Fetch file in its original state, without any processing by the Wayback Machine or waybackpack.

--root ROOT The root URL from which to serve snapshotted resources. Default: 'https://web.archive.org'

--from-date FROM_DATE

Timestamp-string indicating the earliest snapshot to download. Should take the format YYYYMMDDhhss, though you can omit as many of the trailing digits as you like.

E.g., '201501' is valid.

--to-date TO_DATE Timestamp-string indicating the latest snapshot to download. Should take the format YYYYMMDDhhss, though you can omit as many of the trailing digits as you like.

E.g., '201604' is valid.

--user-agent USER_AGENT

The User-Agent header to send along with your requests to the Wayback Machine. If possible, please include the phrase 'waybackpack' and your email address. That

way, if you're battering their servers, they know who to contact. Default: 'waybackpack'.

--follow-redirects Follow redirects.

--uniques-only Download only the first version of duplicate files.

--collapse COLLAPSE An archive.org `collapse` parameter. Cf.: https://github.com/internetarchive/wayback/blob/master/wayback-cdx-server/README.md#collapsing

--ignore-errors Don't crash on non-HTTP errors e.g., the requests library's ChunkedEncodingError. Instead, log error and continue. Cf.

https://github.com/jsvine/waybackpack/issues/19

--quiet Don't log progress to stderr.Por ejemplo, para descargar todas las copias de la página principal del sitio web suip.biz, a partir de la fecha (--to-date 2020), estas páginas deben colocarse en la carpeta (-d /home/esgeeks/pentest), mientras que el programa debe seguir las redirecciones HTTP (--follow-redirects):

waybackpack suip.biz -d ./suip.biz-copy --to-date 2020 --follow-redirects

Estructura del directorio:

tree suip.biz-copy/Para mostrar una lista de todas las copias disponibles en el Internet Archive (--list) para el sitio especificado (esgeeks.com):

waybackpack esgeeks.com --list

Cómo Averiguar Todas las Páginas de un Sitio que están Guardadas en Internet Archive

Para obtener los enlaces que están guardados en Internet Archive, utiliza el programa waybackurls.

Este programa recupera todas las URL del dominio especificado que Wayback Machine conoce. Esto puede utilizarse para mapear rápidamente un sitio.

Cómo instalar waybackurls en Kali Linux o Parrot OS:

Empieza por instalar Go, luego escribe:

go get github.com/tomnomnom/waybackurlsAñade el siguiente código en tu archivo .bashrc:

nano ~/.bashrc

#Añade

export PATH="$PATH:$HOME/go/bin"Entonces:

waybackurls --helpPuedes trabajar con una lista de dominios obteniéndola de la entrada estándar. En esta lista, cada dominio debe ser escrito en una línea separada.

El programa lee los dominios desde la entrada estándar, por lo tanto, para empezar a recibir las direcciones de página de un dominio, es necesario utilizar un comando como este:

echo DOMINIO| waybackurlsPara obtener todas las URL de muchos sitios como DOMINIOS.txt, es necesario especificar un archivo que enumere todos los dominios en el formato de un dominio por línea:

cat DOMINIOS.txt | waybackurlsOpciones:

Usage of waybackurls:

-dates

show date of fetch in the first column

-get-versions

list URLs for crawled versions of input URL(s)

-no-subs

don't include subdomains of the target domainPara obtener una lista de todas las páginas que Wayback Machine conoce del dominio suip.biz:

echo suip.biz | waybackurls

Conclusión

Un par de programas más que también funcionan con el Internet archive:

- https://github.com/relrelb/wayback-downloader

- https://github.com/erlange/wbm-dl

También recomiendo utilizar ArchiveFuzz para encontrar activos de WebArchives y revisar nuestra guía introductoria WayBak Machine para reconocimiento pasivo.